ж·ұеәҰзҘһз»ҸзҪ‘з»ңе°ұеғҸйҒҘиҝңең°е№ізәҝдёҠзҡ„жө·е•ёдёҖж ·ж¶ҢжқҘгҖӮ

йүҙдәҺиҜҘжҠҖжңҜд»ҚеңЁжј”еҸҳзҡ„з®—жі•е’Ңеә”з”ЁпјҢзӣ®еүҚиҝҳдёҚжё…жҘҡж·ұеәҰзҘһз»ҸзҪ‘з»ңпјҲDNNsпјүжңҖз»ҲдјҡеёҰжқҘд»Җд№ҲеҸҳеҢ–гҖӮдҪҶжҳҜпјҢиҝ„д»ҠдёәжӯўпјҢе®ғ们еңЁзҝ»иҜ‘ж–Үжң¬гҖҒиҜҶеҲ«еӣҫеғҸе’ҢиҜӯиЁҖж–№йқўжүҖеҸ–еҫ—зҡ„жҲҗе°ұпјҢжё…жҘҡең°иЎЁжҳҺ他们е°ҶйҮҚеЎ‘и®Ўз®—жңәи®ҫи®ЎпјҢиҖҢиҝҷз§ҚеҸҳеҢ–жӯЈеңЁеҚҠеҜјдҪ“и®ҫи®Ўе’ҢеҲ¶йҖ ж–№йқўеҸ‘з”ҹеҗҢж ·ж·ұеҲ»зҡ„еҸҳеҢ–гҖӮ

йҮҸиә«е®ҡеҲ¶зҡ„第дёҖжү№е•Ҷз”ЁиҠҜзүҮе°ҶдәҺд»Ҡе№ҙдёҠеёӮгҖӮз”ұдәҺи®ӯз»ғж–°зҡ„зҘһз»ҸзҪ‘з»ңжЁЎеһӢеҸҜиғҪйңҖиҰҒеҮ е‘ЁжҲ–еҮ дёӘжңҲзҡ„ж—¶й—ҙпјҢеӣ жӯӨиҝҷдәӣиҠҜзүҮеҸҜиғҪжҳҜиҝ„д»ҠдёәжӯўеҲ¶йҖ зҡ„жңҖеӨ§зҡ„пјҢеӣ жӯӨд№ҹжҳҜжңҖжҳӮиҙөзҡ„еӨ§и§„жЁЎе•Ҷз”ЁйӣҶжҲҗз”өи·ҜиҠҜзүҮгҖӮ

д»Ҡе№ҙзҡ„иЎҢдёҡеҸҜиғҪдјҡзңӢеҲ°жқҘиҮӘеҲӣдёҡе…¬еҸёGraphcoreзҡ„дёҖж¬ҫеҫ®еӨ„зҗҶеҷЁпјҢиҜҘе…¬еҸёдёҚдҪҝз”ЁDRAMпјҢиҖҢжҳҜжқҘиҮӘз«һдәүеҜ№жүӢCerebras Systemsзҡ„жҷ¶еңҶзә§йӣҶжҲҗејҖжӢ“е…Ҳй”ӢгҖӮиӢұзү№е°”收иҙӯзҡ„2.5-D NervanaиҠҜзүҮе·Із»ҸеңЁз”ҹдә§ж ·зүҮпјҢе…¶д»–еҚҒеҮ дёӘеӨ„зҗҶеҷЁжӯЈеңЁејҖеҸ‘дёӯгҖӮеҗҢж—¶пјҢд»ҺArmеҲ°иҘҝйғЁж•°жҚ®пјҲWestern Digitalпјүзҡ„иҠҜзүҮе…¬еҸёжӯЈеңЁз ”究еҶ…ж ёпјҢд»ҘеҠ йҖҹж·ұеұӮзҘһз»ҸзҪ‘з»ңзҡ„жҺЁзҗҶйғЁеҲҶгҖӮ

вҖңжҲ‘и®ӨдёәпјҲ2018е№ҙпјүе°ҶжҳҜдёҖеңәеҚіе°ҶеҲ°жқҘзҡ„жҙҫеҜ№гҖӮвҖқеҠ е·һеӨ§еӯҰдјҜе…ӢеҲ©еҲҶж ЎеҗҚиӘүж•ҷжҺҲеӨ§еҚ«В·её•зү№жЈ®пјҲDavid PattersonпјүиЎЁзӨәпјҡвҖңжҲ‘们еҲҡеҲҡејҖе§ӢзңӢеҲ°и®ёеӨҡе…¬еҸёжӯЈеңЁиҜ„дј°дёҖдәӣжғіжі•гҖӮвҖқ

иҝҷдёӘи¶ӢеҠҝйқһеёёжҳҺжҳҫпјҢеё•зү№жЈ®е’ҢеҗҲзқҖиҖ…зәҰзҝ°В·дәЁе°јиҘҝпјҲJohn HennesseyпјүеңЁдёҠдёӘжңҲеҸ‘иЎЁзҡ„е…ідәҺи®Ўз®—жңәзҡ„ејҖеҲӣжҖ§ж–Үжң¬зҡ„жңҖж–°зүҲжң¬дёӯпјҢдёәе®ғеҶҷдәҶдёҖдёӘж–°зҡ„зҜҮз« гҖӮдҪңиҖ…еҜ№еҶ…йғЁи®ҫи®ЎжҸҗдҫӣдәҶж·ұе…Ҙзҡ„и§Ғи§ЈпјҢдҫӢеҰӮPattersonдёәе…¶иҙЎзҢ®зҡ„Google TensorFlowеӨ„зҗҶеҷЁпјҲTPUпјүпјҢд»ҘеҸҠжңҖж–°Appleе’ҢGoogleжҷәиғҪжүӢжңәиҠҜзүҮдёӯзҡ„Microsoft Catapult FPGAе’ҢжҺЁзҗҶжЁЎеқ—гҖӮ

вҖңиҝҷжҳҜи®Ўз®—жңәдҪ“зі»з»“жһ„е’Ңе°ҒиЈ…зҡ„еӨҚе…ҙгҖӮвҖқ PattersonиҜҙпјҡвҖңжҳҺе№ҙжҲ‘们дјҡзңӢеҲ°жҜ”иҝҮеҺ»еҚҒе№ҙжӣҙжңүи¶Јзҡ„з”өи„‘гҖӮвҖқ

ж·ұеәҰзҘһз»ҸзҪ‘з»ңзҡ„е…ҙиө·еңЁиҝҮеҺ»еҮ е№ҙйҮҢжҠҠйЈҺйҷ©жҠ•иө„зҡ„иө„йҮ‘еёҰеӣһеҲ°дәҶеҚҠеҜјдҪ“йўҶеҹҹгҖӮ вҖңEE Times(з”өеӯҗе·ҘзЁӢдё“иҫ‘зҫҺеӣҪзүҲпјүвҖқжңҖж–°жҺЁеҮәзҡ„еҲқеҲӣе…¬еҸёиҜ„йҖүйЎ№зӣ®вҖңSilicon 60вҖқдёӯпјҢеҲ—дёҫдәҶдёғ家еҲқеҲӣе…¬еҸёпјҢе…¶дёӯеҢ…жӢ¬дёӨдёӘйІңдёәдәәзҹҘзҡ„еҗҚз§°пјҡеҜ’жӯҰзәӘ科жҠҖCambricon TechnologiesпјҲеҢ—дә¬еҜ’жӯҰзәӘ科жҠҖпјүе’ҢMythic Inc.пјҲAustinпјҢTexasпјүгҖӮ

вҖңжҲ‘们зңӢеҲ°еҹәдәҺж–°жһ¶жһ„зҡ„ж–°еҲӣе…¬еҸёжҝҖеўһгҖӮжҲ‘иҮӘе·ұи·ҹиёӘдәҶ15еҲ°20家......иҝҮеҺ»10еҲ°15е№ҙдёӯпјҢеңЁд»»дҪ•дёҖдёӘз»ҶеҲҶйўҶеҹҹдёӯеҚҠеҜјдҪ“иЎҢдёҡйғҪдёҚжӣҫжңүи¶…иҝҮ15家зҡ„еҚҠеҜјдҪ“е…¬еҸёеҗҢж—¶ж¶ҢзҺ°зҡ„дәӢжғ…вҖқпјҢдјҒдёҡ家Chris RowenиҜҙгҖӮд»–д»ҺCadence Design SystemsзҰ»иҒҢеҗҺпјҢжҲҗз«ӢдәҶдёҖ家公еҸёCognite VenturesпјҢдё“жіЁдәҺзҘһз»ҸзҪ‘з»ңиҪҜ件гҖӮ

вҖңNvidiaз”ұдәҺе…¶ејәеӨ§зҡ„иҪҜ件ең°дҪҚпјҢе°Ҷйҡҫд»ҘдёҺй«ҳз«ҜжңҚеҠЎеҷЁиҝӣиЎҢи®ӯз»ғзҡ„з«һдәүгҖӮеҰӮжһңдҪ еҺ»иҝҪжұӮжҷәиғҪжүӢжңәеёӮеңәдҪ дјҡи§үеҫ—иҮӘе·ұз–ҜдәҶпјҢеӣ дёәдҪ еҝ…йЎ»еңЁеҫҲеӨҡж–№йқўйғҪеҒҡеҫ—еҮәиүІгҖӮдёҚиҝҮеңЁй«ҳз«ҜжҲ–жҳҜдҪҺз«Ҝзҡ„жҷәиғҪжүӢжңәеёӮеңәпјҢиҝҳжҳҜдјҡеҸҜиғҪжңүдёҖдәӣжңәдјҡгҖӮвҖқзҪ—ж–ҮиҜҙгҖӮ

еёӮеңәи§ӮеҜҹ家LinleyйӣҶеӣўиҙҹиҙЈдәәLinley GwennapиЎЁзӨәпјҢNvidiaеңЁжңҖж–°зҡ„GPUпјҲVoltaпјүж–№йқўеҒҡеҫ—йқһеёёеҮәиүІпјҢ他们и°ғж•ҙдәҶеҜ№DNNзҡ„йҖҹеәҰеҹ№и®ӯгҖӮ вҖңдҪҶжҲ‘еҪ“然дёҚи®ӨдёәиҝҷжҳҜжңҖеҘҪзҡ„и®ҫи®ЎпјҢвҖқGwennapиҜҙгҖӮ

GwennapиҜҙпјҢGraphcoreпјҲиӢұеӣҪеёғйҮҢж–Ҝжүҳе°”пјүе’ҢCerebrasпјҲеҠ еҲ©зҰҸе°јдәҡе·һLos AltosпјүжҳҜеҹ№и®ӯиҠҜзүҮжңҖеӨҡзҡ„дёӨ家еҲқеҲӣе…¬еҸёпјҢеӣ дёә他们зӯ№йӣҶзҡ„иө„йҮ‘жңҖеӨҡпјҢиҖҢдё”дјјд№ҺжӢҘжңүжңҖеҘҪзҡ„еӣўйҳҹгҖӮз”ұGoogleеүҚиҠҜзүҮи®ҫи®ЎеёҲеҲӣз«Ӣзҡ„еҲқеҲӣе…¬еҸёGroqеЈ°з§°пјҢе®ғе°ҶеңЁ2018е№ҙжҺЁеҮәдёҖж¬ҫжҺЁзҗҶиҠҜзүҮпјҢеңЁжҜҸз§’зҡ„жҖ»ж“ҚдҪңе’ҢжҺЁи®әдёӯйғҪдјҡд»ҘеӣӣеҖҚзҡ„дјҳеҠҝеҮ»иҙҘз«һдәүеҜ№жүӢгҖӮ

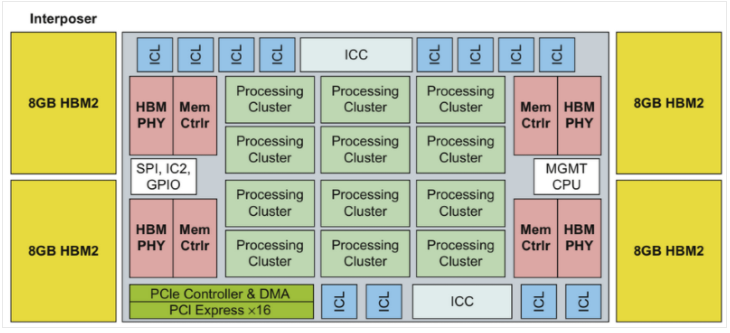

иӢұзү№е°”зҡ„NervanaжҳҜдёҖдёӘеӨ§еһӢзәҝжҖ§д»Јж•°еҠ йҖҹеҷЁпјҢдҪҚдәҺзЎ…дёӯд»ӢеұӮдёҠпјҢзҙ§йӮ»еӣӣдёӘ8-GB HBM2еӯҳеӮЁеҷЁе Ҷж ҲгҖӮж¶ҲжҒҜжқҘжәҗпјҡHennessyе’ҢPattersonзқҖеҶҷзҡ„гҖҠи®Ўз®—жңәдҪ“зі»з»“жһ„пјҡдёҖз§Қе®ҡйҮҸж–№жі•гҖӢ

Intelзҡ„NervanaпјҢиў«з§°дёәLake CrestпјҲдёҠеӣҫпјүпјҢжҳҜжңҖеҸ—е…іжіЁзҡ„е®ҡеҲ¶и®ҫи®Ўд№ӢдёҖгҖӮе®ғжү§иЎҢ16дҪҚзҹ©йҳөж“ҚдҪңпјҢж•°жҚ®е…ұдә«жҢҮд»ӨйӣҶдёӯжҸҗдҫӣзҡ„еҚ•дёӘ5дҪҚжҢҮж•°гҖӮ

дёҺNvidiaзҡ„VoltaдёҖж ·пјҢLake CrestйҖ»иҫ‘еҷЁд»¶дҪҚдәҺTSMCзҡ„CoWoSпјҲиЎ¬еә•дёҠиҠҜзүҮдёҠиҠҜзүҮпјүдёӯд»ӢеұӮдёҠпјҢзҙ§йӮ»зқҖеӣӣдёӘHBM2й«ҳеёҰе®ҪеӯҳеӮЁеҷЁе Ҷж ҲгҖӮиҝҷдәӣиҠҜзүҮиў«и®ҫи®ЎжҲҗзҪ‘зҠ¶пјҢжҸҗдҫӣдә”еҲ°еҚҒеҖҚдәҺVoltaзҡ„жҖ§иғҪгҖӮ

иҷҪ然еҺ»е№ҙеҫ®иҪҜеңЁDNNдёҠдҪҝз”ЁдәҶFPGAпјҢдҪҶPattersonд»Қ然еҜ№иҝҷз§Қж–№жі•жҢҒжҖҖз–‘жҖҒеәҰгҖӮ вҖңдҪ дёәпјҲFPGAпјүзҡ„зҒөжҙ»жҖ§д»ҳеҮәдәҶеҫҲеӨҡд»Јд»·гҖӮзј–зЁӢзңҹзҡ„еҫҲйҡҫпјҢвҖқд»–иҜҙгҖӮ

GwennapеңЁеҺ»е№ҙе№ҙеә•зҡ„дёҖйЎ№еҲҶжһҗдёӯжҢҮеҮәпјҢDSPд№ҹе°ҶеҸ‘жҢҘдҪңз”ЁгҖӮ CadenceгҖҒCevaе’ҢSynopsysйғҪжҸҗдҫӣйқўеҗ‘зҘһз»ҸзҪ‘з»ңзҡ„DSPеҶ…ж ёпјҢд»–иҜҙгҖӮ

иҷҪ然иҠҜзүҮеҚіе°Ҷй—®дё–пјҢдҪҶжҳҜжһ¶жһ„еёҲ们иҝҳжІЎжңүеҶіе®ҡеҰӮдҪ•еҺ»иҜ„дј°е®ғ们гҖӮ

е°ұеғҸRISCеӨ„зҗҶеҷЁзҡ„ж—©жңҹпјҢPattersonеӣһеҝҶиҜҙпјҢвҖңжҜҸдёӘе…¬еҸёйғҪдјҡиҜҙпјҢ'дҪ дёҚиғҪзӣёдҝЎеҲ«дәәзҡ„еҹәеҮҶпјҢдҪҶжҳҜдҪ еҸҜд»ҘзӣёдҝЎжҲ‘зҡ„'пјҢйӮЈдёҚеӨӘеҘҪгҖӮ

йӮЈж—¶пјҢRISCдҫӣеә”е•ҶеңЁSPECеҹәеҮҶжөӢиҜ•дёӯиҝӣиЎҢдәҶеҗҲдҪңгҖӮзҺ°еңЁпјҢDNNеҠ йҖҹеҷЁйңҖиҰҒиҮӘе·ұе®ҡд№үзҡ„жөӢиҜ•еҘ—件пјҢж¶өзӣ–еҗ„з§Қж•°жҚ®зұ»еһӢзҡ„и®ӯз»ғе’ҢжҺЁзҗҶд»ҘеҸҠзӢ¬з«Ӣзҡ„жҲ–жҳҜйӣҶзҫӨзҡ„иҠҜзүҮгҖӮ

еҗ¬еҸ–дәҶиҝҷдёӘе‘јеҗҒпјҢдәӨжҳ“еӨ„зҗҶжҖ§иғҪ委е‘ҳдјҡпјҲTPCпјүжҳҜдёҖдёӘз”ұ20еӨҡдёӘйЎ¶зә§жңҚеҠЎеҷЁе’ҢиҪҜ件еҲ¶йҖ е•Ҷз»„жҲҗзҡ„е°Ҹз»„пјҢ12жңҲ12ж—Ҙе®Јеёғе·Із»Ҹз»„е»әдәҶдёҖдёӘе·ҘдҪңз»„жқҘе®ҡд№үжңәеҷЁеӯҰд№ зҡ„硬件е’ҢиҪҜ件еҹәеҮҶгҖӮ TPC-AI委е‘ҳдјҡдё»еёӯRaghu NambiarиЎЁзӨәпјҢзӣ®ж ҮжҳҜеҲӣе»әдёҺеҠ йҖҹеҷЁжҳҜCPUиҝҳжҳҜGPUзҡ„жөӢиҜ•гҖӮдҪҶжҳҜпјҢиҝҷдёӘеӣўйҳҹзҡ„жҲҗе‘ҳеҗҚеҚ•е’Ңж—¶й—ҙжЎҶжһ¶иҝҳеӨ„дәҺдёҚж–ӯеҸҳеҢ–д№ӢдёӯгҖӮ

зҷҫеәҰе…¬еҸёдәҺ2016е№ҙ9жңҲеҸ‘еёғдәҶдёҖдёӘеҹәдәҺе…¶ж·ұеәҰеӯҰд№ е·ҘдҪңиҙҹиҪҪзҡ„ејҖж”ҫжәҗд»Јз ҒеҹәеҮҶжөӢиҜ•е·Ҙе…·пјҢдҪҝз”Ё32дҪҚжө®зӮ№ж•°еӯҰиҝӣиЎҢи®ӯз»ғд»»еҠЎгҖӮе®ғеңЁе…ӯжңҲд»Ҫжӣҙж–°дәҶDeepBenchд»Ҙж¶өзӣ–жҺЁзҗҶе·ҘдҪңе’Ң16дҪҚж•°еӯҰзҡ„дҪҝз”ЁгҖӮ

е“ҲдҪӣз ”з©¶дәәе‘ҳеҸ‘иЎЁзҡ„FathomеҘ—件дёӯе®ҡд№үзҡ„е…«дёӘAIе·ҘдҪңиҙҹиҪҪж”ҜжҢҒж•ҙж•°е’Ңжө®зӮ№ж•°жҚ®гҖӮеё•зү№жЈ®иҜҙпјҡвҖңиҝҷжҳҜдёҖдёӘејҖе§ӢпјҢдҪҶжҳҜиҰҒиҺ·еҫ—дёҖдёӘи®©дәәж„ҹи§үиҲ’йҖӮзҡ„е…ЁйқўеҹәеҮҶжөӢиҜ•еҘ—件пјҢиҝҳйңҖиҰҒжӣҙеӨҡзҡ„е·ҘдҪңгҖӮвҖқ

вҖңеҰӮжһңжҲ‘们жҠҠеҠӘеҠӣеҒҡжҲҗдёҖдёӘеҘҪзҡ„еҹәеҮҶпјҢйӮЈд№ҲжүҖжңүжҠ•е…Ҙе·ҘзЁӢзҡ„й’ұйғҪдјҡиҠұеҫ—еҖјеҫ—гҖӮвҖқд»–иҜҙгҖӮ

йҷӨдәҶеҹәеҮҶд№ӢеӨ–пјҢе·ҘзЁӢеёҲйңҖиҰҒи·ҹиёӘд»ҚеңЁжј”еҸҳзҡ„зҘһз»ҸзҪ‘з»ңз®—жі•пјҢд»ҘзЎ®дҝқ他们зҡ„и®ҫи®ЎдёҚдјҡиў«жқҹд№Ӣй«ҳйҳҒгҖӮ

й«ҳйҖҡе…¬еҸёдёӢдёҖд»Јж ёеҝғз ”еҸ‘жҖ»зӣ‘Karam ChathaиЎЁзӨәпјҡвҖңиҪҜ件жҖ»жҳҜеңЁеҸҳеҢ–пјҢдҪҶжҳҜдҪ йңҖиҰҒе°Ҫж—©жҠҠ硬件жӢҝеҮәжқҘпјҢеӣ дёәе®ғдјҡеҪұе“ҚиҪҜ件- дҪ дёҚеҫ—дёҚеӮ¬дҝғи®©е®ғеҸ‘з”ҹгҖӮеҲ°зӣ®еүҚдёәжӯўпјҢ移еҠЁиҠҜзүҮдҫӣеә”е•ҶжӯЈеңЁйӘҒйҫҷSoCзҡ„DSPе’ҢGPUеҶ…ж ёдёҠиҝҗиЎҢзҘһз»ҸзҪ‘з»ңе·ҘдҪңпјҢдҪҶдёҖдәӣи§ӮеҜҹ家预计пјҢе®ғе°ҶдёәжңәеҷЁеӯҰд№ е®ҡеҲ¶дёҖдёӘж–°зҡ„жЁЎеқ—пјҢ ж”ҫеңЁ2019е№ҙ7зәізұійӘҒйҫҷSoCйҮҢгҖӮ

PattersonиҜҙпјҡвҖңеёӮеңәеҶіе®ҡе“Әз§ҚиҠҜзүҮжңҖеҘҪгҖӮ вҖңиҝҷжҳҜж®Ӣй…·зҡ„пјҢдҪҶиҝҷжҳҜи®ҫи®Ўз”өи„‘и®©дәәе…ҙеҘӢд№ӢеӨ„гҖӮ вҖқ

ж—©жңҹиҝӣе…Ҙзҡ„зҺ©е®¶е·Із»Ҹжңүжңәдјҡиҝӣе…ҘеҲ°жёёжҲҸдёӯгҖӮ

дҫӢеҰӮпјҢFacebookжңҖиҝ‘иҜҒжҳҺпјҢйҖҡиҝҮеӨ§е№…еўһеҠ жү“еҢ…еҲ°жүҖи°“жү№йҮҸеӨ§е°Ҹзҡ„еҠҹиғҪж•°йҮҸпјҢеҸҜд»Ҙе°Ҷеҹ№и®ӯж—¶й—ҙд»ҺдёҖеӨ©зј©зҹӯеҲ°дёҖе°Ҹж—¶гҖӮеҜ№дәҺиҜ•еӣҫеңЁжң¬ең°SRAMдёӯиҝҗиЎҢжүҖжңүж“ҚдҪңзҡ„GraphcoreжқҘиҜҙиҝҷеҸҜиғҪжҳҜдёӘеқҸж¶ҲжҒҜпјҢж¶ҲйҷӨдәҶеӨ–йғЁDRAMи®ҝй—®зҡ„延иҝҹпјҢеҗҢж—¶д№ҹйҷҗеҲ¶дәҶе®ғзҡ„еҶ…еӯҳеҚ з”ЁгҖӮ

вҖң他们дёәе°Ҹжү№йҮҸж•°жҚ®еҢ…иҖҢи®ҫи®Ўзҡ„пјҢдҪҶеҮ дёӘжңҲеүҚзҡ„иҪҜ件结жһңиЎЁжҳҺдҪ жғіиҰҒдёҖдёӘеӨ§жү№йҮҸж•°жҚ®еҢ…гҖӮиҝҷиЎЁжҳҺдәӢжғ…еҸҳеҢ–зҡ„йҖҹеәҰжңүеӨҡеҝ«пјҢвҖңеё•зү№жЈ®иҜҙгҖӮ

еҸҰдёҖж–№йқўпјҢйӣ·е…Ӣж–Ҝз”өи„‘(Rex Computing)и®ӨдёәжӯЈеңЁиҝҺжқҘдёҖдёӘжңүеҲ©зҡ„жңәйҒҮгҖӮиҜҘеҲқеҲӣе…¬еҸёзҡ„SoCжңҖеҲқжҳҜдёәй«ҳжҖ§иғҪжңҚеҠЎеҷЁи®ҫи®Ўзҡ„пјҢе®ғдҪҝз”ЁдәҶдёҖз§Қж–°йў–зҡ„жҡӮеӯҳеҷЁеҶ…еӯҳгҖӮ Rexзҡ„ж–№жі•ж¶ҲйҷӨдәҶеңЁиҷҡжӢҹйЎөйқўиЎЁдёӯзј“еӯҳж•°жҚ®зҡ„йңҖжұӮпјҢиҝҷжҳҜGPUдҪҝз”Ёзҡ„дёҖз§ҚжҠҖжңҜпјҢеўһеҠ дәҶ他们зҡ„延иҝҹпјҢиҒ”еҗҲеҲӣе§ӢдәәThomas SohmersиҜҙгҖӮ

еӣ жӯӨпјҢRexиҠҜзүҮжҜ”зҺ°еңЁзҡ„GPUиҰҒеҘҪеҫ—еӨҡпјҢзү№еҲ«жҳҜеңЁеӨ„зҗҶжөҒиЎҢзҡ„зҹ©йҳө/зҹўйҮҸиҝҗз®—зҘһз»ҸзҪ‘з»ңж—¶пјҢд»–иҜҙгҖӮж–°еҲӣе…¬еҸёи®ЎеҲ’6жңҲд»ҪжҺЁеҮә16зәізұізҡ„256ж ёзҡ„SoCпјҢеёҢжңӣиғҪжҸҗдҫӣ256 Gflops / wattзҡ„иҝҗз®—иғҪеҠӣгҖӮ

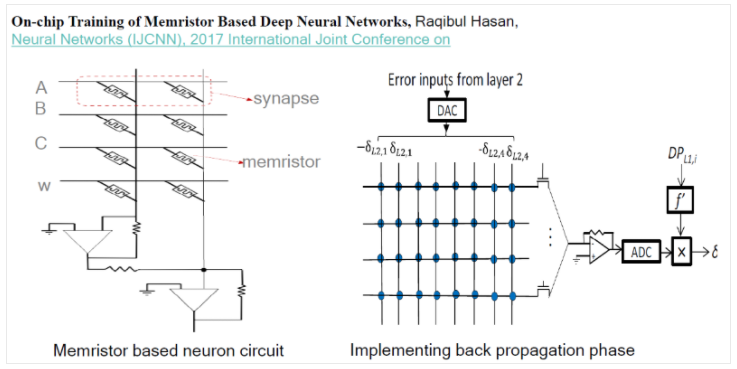

дёҺжӯӨеҗҢж—¶пјҢз ”з©¶дәәе‘ҳжӯЈеңЁе°қиҜ•д»Һ32дҪҚеҲ°еҚ•дҪҚжө®зӮ№е’Ңж•ҙж•°ж•°еӯҰзҡ„дёҖеҲҮеҸҜиғҪпјҢд»ҘжүҫеҲ°жңҖжңүж•Ҳзҡ„ж–№жі•жқҘи®Ўз®—зҘһз»ҸзҪ‘з»ңз»“жһңгҖӮ他们似д№ҺеҗҢж„Ҹзҡ„дёҖзӮ№жҳҜпјҢжңҖеҘҪдёҚиҰҒеңЁзІҫзЎ®еәҰзә§еҲ«д№Ӣй—ҙиҪ¬жҚўгҖӮ

зј–иҜ‘пјҡMike Zhang

ж–Үз« жқҘжәҗ: eMedia Asia Ltd.

е…іжіЁиЎҢдёҡеҠЁжҖҒпјҢдәҶи§Јдә§дёҡдҝЎжҒҜпјҢд»Ҙе®һзҺ°дёҺж—¶дҝұиҝӣпјҢејҖжӢ“еҲӣж–°пјҢзЁіжӯҘеҸ‘еұ•гҖӮ

ж Үзӯҫ: дәәе·ҘжҷәиғҪ иҠҜзүҮ